Google搜索新推算法BERT是什么 Google搜索将更理解句子中单词的关系

Google搜索引擎新推的BERT算法是什么意思?有什么作用?对搜索结果有什么改变?谷歌搜索英文版于2019年10月25日上线BERT算法,让搜索更理解用户搜索词的含义。谷歌对中文搜索词的理解拼不过百度,因为中文的一词多义连平常人都需要动脑筋。在长句里,更是难以梳理句子的结构。不过,谷歌最近推出的算法BERT就不一样了。下面来看看谷歌搜索算法BERT的介绍。

2019 年 10 月 25 日,Google 宣布 BERT 更新上线,可以以更接近人的方式去理解 Query(用户搜索词)的含义,从而提升搜索体验,预计影响 10% 的英文搜索。

Google 称 BERT 算法是过去五年来突破最大的算法,也是 Google 搜索历史上突破最大的算法之一。

1.Google为何要推出BERT算法

在阅读英语文章时,最让你挠头的是什么?遇到一词多意时不知道该选哪个解释?还是长句里难以梳理的信息结构?Google搜索引擎其实也跟你一样挠头。

为了「照顾」Google搜索引擎,很多人在搜索时会用「关键词搜索法(keyword-ese)」—— 只输入关键词,不使用完整的句子。譬如,有人会在搜索栏里输入 「痣」「臀部」「癌症」,其实他想问的是「我屁股上的痣是不是癌症的征兆?」

▲ 图自 Neringa Šidlauskaitė viaUnsplash

最近,Google为搜索引擎引入了一个名为 「BERT(Bidirectional Encoder Representations from Transformers)」的机器学习算法,帮助前者更好地理解用户在搜索栏提出的问题。

2.引擎更新后有什么改变?

简单来说,加入BERT后的 Google搜索引擎,能够更好地理解接近自然对话的长句子,因为它能更好地分析了解句子中单词间的关系。

▲ 图自Unsplash

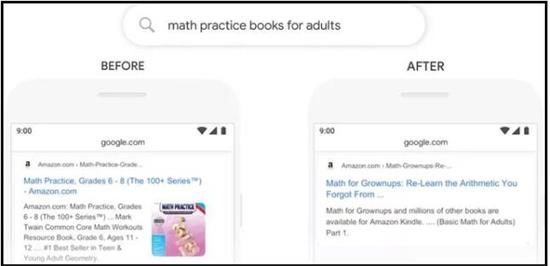

和传统算法不同的是,BERT在分析词语时,并不是依次从左到右或从右到左地逐词分析,而是借助 Google研发的 Transformer 模型并行分析词语在整个句子中的关系。譬如,如果搜索「math practice books for adults(给成年人的数学练习册)」,更新前的搜索返回结果会将「adults(成年人)」变为「young adults(年轻人)」,更新后则不会这样。

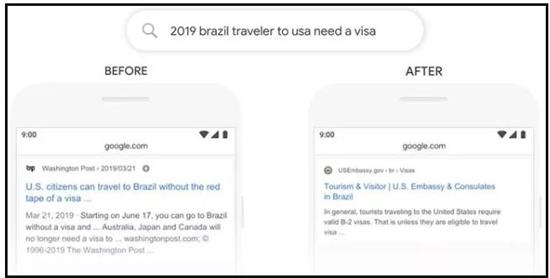

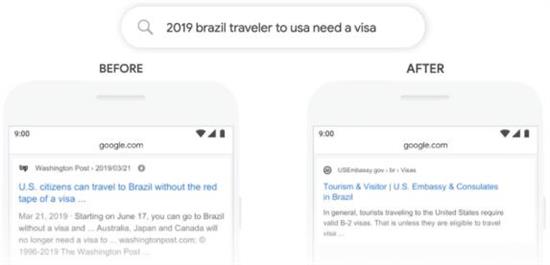

此外,在介词对整个句子意思影响较大的情况下,加入BERT后的理解能力也明显优于从前。搜索「2019 Brazil traveler to usa need a visa(2019 巴西旅客到美国需要签证)」,在更新前,搜索引擎没有将「to」考虑在内,更多返回了美国旅客到巴西旅行的信息。加入BERT后,「to」则没有被忽略。

对于这次更新,Google副总裁 Pandu Nayak 在官方博文中称之为「代表了五年里最大的跨越,也是搜索历史上其中一个最大的改进」。目前,BERT已经应用到 Google搜索的英文版中,未来还将扩展到更多不同语言版本。

3.BERT或能让算法更会「聊天」

据《Fastcompany》报道,为了训练BERT,Google向其输入了 11038 本未经标注的书籍文本和合计 25 亿字来自维基百科英文版的内容。而且,研究人员还随机「掩盖」了文本里的单词,让算法模型自行想法子「填空」。

学习完所有文本后,算法开始找到一些在同一文本中经常出现的句子和词语规律,建立了对词语的基本理解,而且还似乎开始「明白」词语背后所代表的事物之间存在的关系,这就像一种「常识」。

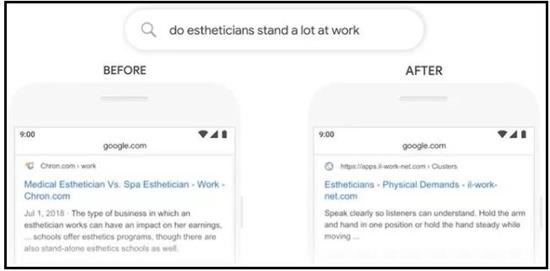

举个例子,从前如果在 Google里搜「do estheticians stand a lot at work(美容师在工作中需要站很久吗)」,搜索引擎会将「stand(站)」这个词语套入「stand-alone(独立)」的意思,因此无法返回搜索者想要的信息。

加入BERT后,搜索引擎则能理解,用户所指的是「站立」的动作,再进一步,也可扩大理解为「美容师这个职业的体力劳动量」。

在处理过程中,系统需要表述它所理解的词语意思,还有句子的结构以及整体内容。结果就是,从某个程度来说,它对语言有一定了解。这挺奇怪的,因为它对现实世界一无所知。它看不到,听不到,什么都没有。人工智能科学家Yann LeCun说道。

4.Facebook为何也需要BERT算法

作为 Facebook的副总裁,LeCun带领着团队,通过对BERT进行优化,并输入更大批量的学习资料,研发出了他们的自有模型「RoBERTa」。Google原有的BERT准确率为 80.5%,而 RoBERTa 则可做到 88.5%。但为什么 Facebook也要研究这个?

如果说当搜索引擎能够更好地理解用户输入的自然语言,反馈更有帮助的内容,那这个改进移植到智能语音助手上也是可预见的。和很多科技巨头公司一样,Facebook也在研发智能语音助手,提升算法对自然语言的处理能力也是必须。

▲ Facebook今年宣布将为 Portal 研发语音助手,图自 Digital Trends

但在语音助手之前,他们先从相对简单的文本对话入手,做了聊天机器人,而且准备在 RoBERTa 的基础上扩展更多功能,让算法和人聊起天来更自然。据 LeCun介绍,很多聊天机器人都会 「把天聊死」。

譬如,很多机器人讲话会自相矛盾。前一分钟可能和你说「XXX 的新单太棒了,赶紧一起去打榜」,下一分钟就说「追星的人都是傻的」。这主要是因为它们背后是一个固定的数据库,收到特定的关键词就会调出对应回答。

而那些真的是自己生成答案的机器人,又会为了规避自相矛盾而用模糊的答案来回应人,显得冷冰冰。

此外,现有聊天机器人大多知识领域很局限。一旦聊天的人改了话题,聊到它不认识的,机器人就接不下话了。为此,Facebook现在正向自己的算法输入来自各种领域的大批量信息,并尝试将这些信息以更自然的方式加入对话中。未来,他们还计划教导机器人「引导话题」—— 当聊天者将话题扯到比较泛的领域时,将内容拉回到特定任务上。

我们相信,我们已经很接近创造出一个能和人们聊得下去的机器人。Facebook研究人员 Jason Weston 告诉《Fastcompany》。在那天到来之前,希望我能练就出不被聊天机器带跑的技能。

5.什么是BERT?

BERT是google最新提出的NLP(natural language processing)预训练方法,在大型文本语料库(如维基百科)上训练通用的“语言理解”模型,然后将该模型用于我们关心的下游NLP任务(如分类、阅读理解)。总而言之,搜索引擎将更好地理解人的语言。

BERT 模型被称为 “最强 NLP 模型”,Google 也在 2018 年底开源了 BERT 模型,相关论文也荣获 NAACL 2018 年的最佳长论文;BERT 算法已经在智能机器人、Feeds 等多个方面实践。

6.BERT具体内容和影响

利用 BERT 算法,Google 可以加强对 Query 的理解,从而影响搜索结果。目前 Google 称大概会影响 10% 的美国地区的英文搜索,之后将推广到其他语言和国家。

Google BERT 算法在 10 月 21 日左右切流,在 27 日完全上线,所以 SEOs 可以具体观测 27 日之后的数据变化。

另外,精选摘要(Featured Snippets)已经在全球 20 多个国家应用了 BERT 算法,比如韩语、印地语、葡萄牙语。

7.BERT算法对搜索结果有什么影响

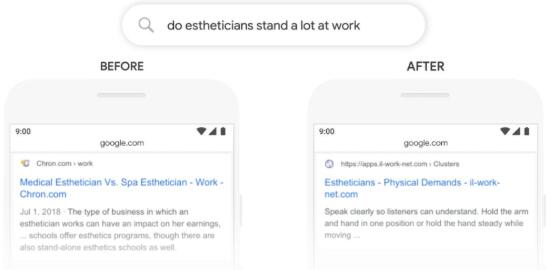

例子1:

以前搜,2019年前往美国的巴西旅行者需要签证,出现的搜索结果是“美国去巴西不需要签证”,而BERT算法更新后,搜索准确度高了很多,直接满足了搜索者的请求。

例子2:

搜索“做美学家的工作量很大”时,谷歌表示,以前会将“独立”一词与查询中使用的“立场”相匹配。而BERT算法更新之后,Google已经能够理解Stand代表的是一种物理上的需求要做很多工作,比之前搜索的结果更加精准。

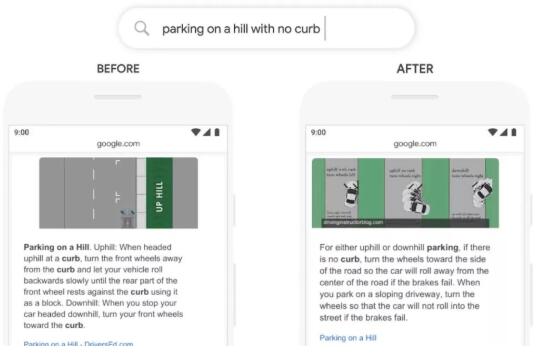

例子3:

在Feature Snippet中,搜索“在没有路边的山坡上如何停车?”,谷歌以前太强调“路边”这个词,所以可以看到搜索结果出现的都是”Curb“为主的内容,但这个内容并不能很好的解决用户的需求。所以BERT出现后,他更好的理解用户当前的需求,Feature Snippet也发生了变化。

8.BERT有什么作用

本次算法是对用户的口语化问题做出更人性化的升级,以前的stop word,比如to、for这些词现在被重视起来了。以前我们在Yoast SEO里面,插件建议我们把stop word尽量少用。但本次算法更新后,我们要合理的把stop word给用起来。

本次算法据searchengineland统计,影响了将近10%的搜索结果,这是一个非常大的搜索结果的变化。因此,这次算法更值得我们去研究新算法BERT下,如何去获取到更多的流量。

还有一点猜想就是:本次BERT算法更新,从某种意义上来讲,是在为以后的智能机器人做铺垫。比如我们用天猫盒子,小米精灵等机器人设备,提出的问题会有对应的回答,但目前还不能很精准的回答出所有的问题。

但随着BERT算法更新后,相信很快这些机器人就能很好的解答我们的问题了。当然,这些回答的数据还是会从网页端进行获取。当你优化好这块的内容并得到不错的排名,机器人会优先使用你的内容来进行解答,但具体这个商业如何变现,就还不得而知。

但,有个风向标很明显:口语化的内容创作将会是我们后续发力的重点。

以上就是谷歌搜索引擎新推出的算法BERT的介绍。BERT有哪些作业,对搜索结果将有哪些改变呢?搜索引擎输入词是用户和搜索机器交互的关键,对输入的搜索词理解如何,成为搜索成功的关键。搜索机器对用户长句、词与词之间的关系的理解,还处在学习阶段,毕竟人工智能对人类自然语言的理解还在进步中。关注教程之家,解锁更多软件教程。