iPhone 14 Pro体验评测_值得买吗[多图]

今年9月,苹果最新的iPhone 14系列已经如期而至了,每年iPhone从发布到上市都会受到非常高的关注,今年也不例外,尤其是今年iPhone 14 Pro系列上灵动岛的加入,4800万像素的升级,卫星通信、车祸检测等人文关怀功能的加入更是让其讨论热烈。但经过一段时间的体验,我对iPhone 14 Pro且有些不一样的使用感受。

iPhone 14 Pro体验评测:综合体验最好的智能手机

如何评价灵动岛

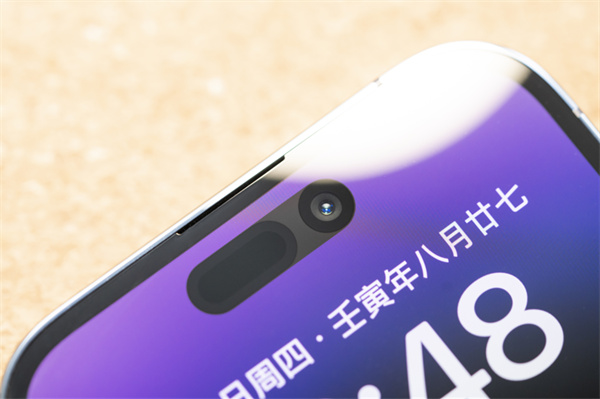

作为iPhone 14 Pro这次最大的一个关注点,或者说讨论点,就让我们从灵动岛开始谈起。

很多人说灵动岛是苹果为了遮丑所作的设计,目的是降低感叹号挖孔所带来的突兀感,对于这个观点,我并不赞同。原因很简单,如果单纯只是为了遮丑,那么从iPhone X到iPhone 13,挖孔面积明显比iPhone 14 Pro更大,苹果为什么这么多年都没去遮?

当然,你要说刘海丑不丑,感叹号挖孔难不难看,那肯定是不如居中打孔和真全面屏漂亮,但这就是另外一个话题了。iPhone 14 Pro的挖孔装了多少颗传感器,那些全面屏手机又装了多少?iPhone这么多年还长这样,并不是苹果做不出全面屏,而是无数权衡与平衡之后的结果。

实际上苹果这几年在无孔化上实现了很多突破,iPhone 13系列的刘海相比之前就缩小了20%,iPhone 14 Pro的原深感摄像头系统又在iPhone 13的基础上缩小了31%,这才实现了整体挖孔面积更小的感叹号。另外,美版的iPhone 14还取消了SIM卡槽的开孔。

我不清楚感叹号挖孔和灵动岛的诞生是否有必然联系,但可以确定的是,灵动岛将苹果软硬一体的优势发挥到了极致,几乎彻底模糊了硬件和软件的界限,无论操作还是体验,完全不需要分辨硬件从哪里开始,软件到哪里结束。

从原理上说,这的确不是一个很难模仿的功能,我们也不难预测,安卓阵营很快就会将灵动岛学习过去,只是最终效果就不得而知了。

现在大家都知道,灵动岛的主要作用其实就3个:1.显示通知,比如插入充电器后,随即显示电量;2.查看实时活动,比如正在听的歌,或者后续第三方App适配后,随时查看专车到哪儿了;3.操控后台App,注意,这是在不影响当前应用界面的情况下实现的,比如一边看PPT,一边切换FaceTime摄像头。

我一周体验下来,你要说有没必要为了灵动岛换iPhone 14 Pro,那倒也大可不必,因为它并不是一个痛点功能。但是,当我再回到没有灵动岛的iPhone 13后,又觉得不太习惯,总觉得缺点啥。

相对功能本身,我更感兴趣的是灵动岛的运作方式,每一个窗口、每一帧动画、每一次交互都做得非常生动、灵敏、自然。正如苹果人机交互设计副总裁AlanDye和灵动岛设计师此前接受媒体采访时所说的那样:灵动岛的设计从一开始就集结了显示器、工业设计与人机界面团队,苹果一直努力在实用性、功能与有趣之间达到平衡,它们彼此互相叠加,融入,形成一个整体。

灵动岛是一个优秀的设计,它模糊了硬件与软件的界限,拓宽了显示与操作的维度,降低了应用与应用之间的干扰。在适度弱化挖孔所带来的不适感的同时,又赋予了iPhone新的交互方式。

当然,灵动岛目前并不完美,除了iPhone自带的App,几乎所有第三方应用都还在适配中,时常会遇到显示和交互上的Bug。如果你是一个强迫症,可以稍微等一两个月再入手,到时这些问题应该会得到大幅改善。

4800万像素主摄画质好么

iPhone 14 Pro的另一大关注点就是拍摄,原因也很简单——从iPhone 6s时代沿用至今的“祖传”1200万像素摄像头,终于升级到4800万了。

从部分参数上看,iPhone 14 Pro相比iPhone 13 Pro是有些“退步”的,比如主摄和超广角的光圈都有所缩小,我猜测可能是处于镜组结构的整体考量。不过第二代传感器位移式光学图像防抖和光像引擎的加入,却赋予了iPhone 14 Pro新的能力,而这种能力体现在拍摄的方方面面。

第二代传感器位移式光学图像防抖很好理解,就是防抖功能更强了,苹果也因此给iPhone 14 Pro的视频拍摄加入了运动模式。光像引擎就更厉害了,简单来说就是苹果新的计算摄影技术,基于强大的硬件算力与神经引擎实现,可以大幅提升低光照环境下的拍摄效果。

我们先来聊聊运动模式。

运动模式,或者说安卓手机的防抖/超级防抖模式并不是什么新功能,很多手机都有,原理也大同小异。就是通过软硬件协同,达到抵消或者削弱画面抖动的目的。iPhone 14 Pro的第二代传感器位移式光学图像防抖就是硬件层面的保障,而软件层面,苹果也是通过裁切画面来实现的。

iPhone 14 Pro的运动模式在所有焦段下都可以使用,由于画面要进行裁切,分辨率最高只能到2.8K 60fps。此外,运动模式对于光线的要求比较高,除了明亮的户外,几乎都会出现“需要更多光线”的提示。当然,不影响正常使用,只是画面质量可能得不到保障。

运动模式的防抖效果,肯定是不如上一个手持稳定器的,在加上对光线和画幅的限制,如果不是有特定需求,没必要刻意开启。苹果做这个功能的目的,还是给普通用户多一种选择。

iPhone 14 Pro的4800万像素主摄也很有意思。我一拿到手机就随手拍了几张照片导到Mac上看,结果还是1200万像素。一查,原来苹果也采用了四合一像素传感器,也就是4个像素合成一个,所以还是1200万像素输出。

但是,我在拍摄界面并没有找到4800万像素的开关,直到进入设置菜单,才在相机-格式-照片拍摄里打开Apple ProRAW格式之后,才能将分辨率设置为48MP。也就是说,只有用Apple ProRAW格式拍摄的照片,才是4800万像素。

那么实际上这个功能的使用场景就比较有限了,因为一般人是不会,甚至不知道Apple ProRAW格式的,苹果默认也是关闭状态。再加上WinPC和非专业软件也打不开Apple ProRAW格式,拍一张4800万像素的照片要占用75MB左右的存储空间,并且还有一定的快门时滞,普通用户街拍发个朋友圈啥的,不建议使用。

下面两张照片都是用Apple ProRAW格式拍摄的,上图为iPhone 13 Pro的1200万像素,下图则是iPhone 14 Pro的4800万像素拍摄。在不放大的情况下,iPhone 13 Pro的画面亮度、锐度和通透度看上去甚至比iPhone 14 Pro更好。

不过放大之后,两者在解析力上的差距就体现出来了。可以看到黄色指示牌上的电话号码,iPhone 14 Pro还可以清晰辨认,而iPhone 13 Pro已经模糊不清。

另外,大家应该已经注意到,两款手机的画面构图有所差异,这是因为iPhone 14 Pro的主摄的等效焦距相比iPhone 13 Pro广了2mm,来到了24mm,可以说是一个非常标准的广角镜头了。

上:iPhone 13 Pro,下:iPhone 14 Pro

100%局部放大,上:iPhone 13 Pro,下:iPhone 14 Pro

到了暗光环境,就更有趣了。

前面提到,iPhone 14 Pro的超广角和主摄的光圈,相比iPhone 13 Pro略有缩小,这在一定程度上降低了iPhone 14 Pro的进光量。通过几组样张大家可以看到,iPhone 13 Pro的画面的确都比iPhone 14 Pro明亮一丢丢。

从样张来看,两者主要的差异还是体现在对高光的压制上,注意几组张片的灯箱区域,iPhone 13 Pro都有些轻微过曝,或者光晕,而iPhone 14 Pro则控制得比较好,光像引擎在其中发挥了重要作用。

表面上我只按下了一次快门,但iPhone 14 Pro可能拍摄了N张照片,然后在多张图像中逐像素比对挑选最优局部,再融合成一张最终成片。这一过程都是在iPhone 14 Pro强大算力的支持下瞬间完成的。

以下3组照片均为上:iPhone 13 Pro,下:iPhone 14 Pro

0.5X

1X

3X

我这段时间使用下来的感觉是,在光线充足的环境下,iPhone 14 Pro和iPhone 13 Pro的画质是拉不开差距的,除了4800万像素输出。而在暗光环境下,用iPhone 14 Pro拍摄还是更稳,可能一眼看上去没有iPhone 13 Pro的画面那么亮,但是整体控制和细节还是要更胜一筹。

如果你是一个普通用户,用它拍照就会觉得很舒服,随手一拍就可以得到高品质的照片。如果你是一个专业用户,或者视频创作者,那么同样能够得到不输专业设备的拍摄体验,尤其是Vlog这种对设备便携性要求较高的题材,我觉得使用iPhone 14 Pro更合适。

A16仿生芯片性能提升有多大

我在iPhone 14 Pro上查看视频素材时,刻意注意了屏幕亮度。坦白说也许是因为素材本身的原因,我并没有在同一段HDR视频中,看出它和iPhone 13 Pro的屏幕亮度有什么明显区别,两者都很亮,日常使用完全足够了。

实际上,这次iPhone 14 Pro的户外峰值亮度提升到了2000nit,也就是把正常情况下的亮度开到最高(1000nit)还要再亮一倍,户外峰值亮度没有开关,只有当传感器检测到环境光非常亮(例如烈日下)的时候才会自动触发。

我怼了几盏影棚的灯上去后成功将它触发,的确是非常的亮,甚至感觉有些刺眼。我估计正常环境下是不容易触发这一亮度的。大家都知道,屏幕亮度高也预示着发热高,一旦过热,iPhone就会自动降低亮度。所以iPhone 14 Pro的2000nit可以理解为一个瞬态Buff,而且还是被动技能。

左:iPhone 14 Pro,右:iPhone 14

相对亮度的提升,全天候显示我觉得才是iPhone 14 Pro屏幕层面最大的升级,虽然这并不是一个新功能,但它的体验却非常的好。

一方面是因为iPhone 14 Pro的全天候显示并不是很多安卓手机那样的AOD显示,也就是整体熄灭,只点亮部分像素。iPhone 14 Pro就是以比较低的亮度和刷新率(1Hz)常亮着,方便用户随时查看时间、小组件或者实时活动。

另一方面,iPhone 14 Pro的全天候显示真的很亮,有多亮呢?大家通过下图可以看到,左边是“息屏”状态下的iPhone 14 Pro,右边则是亮屏状态下的iPhone 13 Pro……刚开始的一两天,我经常觉得它没有息屏。

左:iPhone 14 Pro,右:iPhone 13 Pro

屏幕常亮真的很有用,因为很多人都有强迫症,没事就喜欢把手机点亮看看,有没有消息,或者几点了,我也不例外。用了几天iPhone 14 Pro后,就戒掉了这个习惯,我甚至关掉了抬腕亮屏功能,如果只是看个xi信息,根本不需要点亮屏幕。

大家可能会担心耗电问题,我试了一下,打开和关闭全天候显示使用一天,大概能差几个百分点,基本可以忽略不计。另外,当iPhone 14 Pro检测到手机放在口袋,或者晚上睡觉后,它就会自动息屏。

这些看似普通的功能背后,其实都离不开A16仿生芯片的功劳。

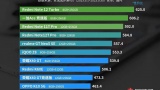

表面上看,A16相比A15性能也就提升了10%,并不夸张。通过Geekbench 5的测试也可以看到,iPhone 13 Pro单核成绩1717,多核4640;iPhone 14 Pro则是单核1887,多核5449,的确都在10%左右。

左:iPhone 13 Pro,右:iPhone 14 Pro

但是别忘了,A15仿生芯片的性能其实都已经是“过剩”的,苹果今年也继续在iPhone 14系列上采用了A15(满血版)芯片,这是第一次同一代iPhone,使用了不同的芯片。从日常体验来看,即便是《原神》这种让旗舰安卓都要全力以赴的应用,A15也可以轻松应对,更别说A16了。

A16的很多新特性,还是用于服务iPhone 14 Pro的新功能,比如新的显示引擎服务灵动岛和全天候显示,使后者能够以极低的功耗运作,灵动岛的动画也可以在硬件和软件之间无缝融合。包括新的图像信号处理器,以支持iPhone 14 Pro的4800万四合一像素传感器。

A16仿生芯片对于苹果来说,不只是让iPhone 14 Pro的性能持续领先,更重要的是,几乎所有功能的实现,都离不开它的支持,这也是iPhone有别于安卓旗舰的最大优势。

左:iPhone 14 Pro,右:iPhone 14

不只是硬件,还有数据与机器学习,比如iPhone 14 Pro这次一个重磅,但希望所有用户一辈子都用不上的功能——车祸检测,用于检测严重车祸的算法根据超过100万小时的真实驾驶和车祸数据训练得出,配合iPhone 14 Pro新的双核加速感应器,能够检测到只有在严重车祸中才会出现的256 G值。

加上新的高动态范围陀螺仪,iPhone 14 Pro能够以4倍的速度进行采样,确保检测到车祸中经历的高G值冲击,然后自动拨打紧急服务电话,并播放循环语音通报车祸和位置给健康App中的指定紧急联系人。

这个功能我就没办法进行测试了,更多是感叹人文与科技的确是写进苹果DNA里的东西,要实现车祸检测这样的功能,除了要有无与伦比的技术实力之外,对人与生命的尊重或许才是推动工程师不断向前的原动力,真的很苹果。

写在最后:

我认为iPhone 14 Pro,或者说这几年iPhone的更新都属于稳步迭代,一步步按照自己的节奏来,暂时没办法剪掉刘海,那就一点点缩小它;既然性能一直是领先的,那么每年提升个10%,继续保持领先就好;相机硬件难有大的提升,就从计算摄影下手……正是基于这样的产品策略,才使得iPhone 14 Pro依然是这个地球上,综合体验最好的智能手机,或许真的没有之一。

站在选购的角度,如果你是iPhone 13 Pro的用户,我觉得没有太大必要为了灵动岛或者4800像素主摄升级,它们都属于“用了可能会回不去,但不用也没啥不得了”的功能。但如果你是iPhone 12 Pro或者基础款数字系列的用户,在预算充足的情况下,我也找不出什么不选择iPhone 14 Pro,而去购买其他安卓旗舰的理由。

![4月3000-4000元性价比手机哪个好_4月3000-4000元性价比手机推荐[多图]](https://img.jiaochengzhijia.com/uploadfile/2022/0510/20220510154605230.jpg@crop@240x180.jpg)

![Brandt白朗A22取暖器评测_怎么样[多图]](https://img.jiaochengzhijia.com/uploadfile/2022/1022/20221022023049570.jpg@crop@240x180.jpg)

![联想ThinkBook 16p 2022评测评测_联想ThinkBook 16p 2022评测怎么样[多图]](https://img.jiaochengzhijia.com/uploadfile/2022/1020/20221020220046548.jpg@crop@240x180.jpg)